Transformer-Modelle sind das Herzstück der KI, versteckt unter deren Motorhaube. Sie sind unverzichtbar für Fortschritte in Bereichen wie der natürlichen Sprachverarbeitung und Bilderkennung.

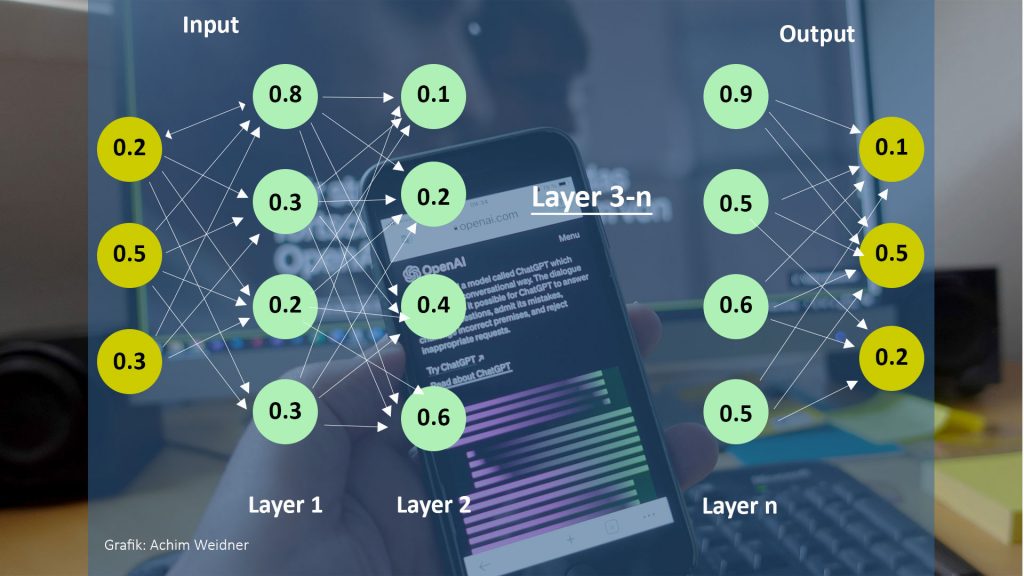

Die Grafik stellt eine schematische Darstellung eines neuronalen Netzwerks dar, eines sogenannten Transformers, der für Verarbeitungsaufgaben in der künstlichen Intelligenz genutzt wird. Auf der linken Seite siehst du die Eingabeschicht (Input), die Daten erhält. Diese werden durch verschiedene Schichten (Layer 1, Layer 2, bis Layer n) verarbeitet, was die Zwischenschichten andeuten. Jede Verbindung repräsentiert dabei ein Gewicht (die Zahlen), das im Lernprozess angepasst wird, um die Ausgabe (Output) zu verbessern. Die Ausgabeschicht rechts gibt die finalen Werte oder Entscheidungen des Netzwerks aus. Diese Art von Netzwerk wird oft für Aufgaben wie Sprachverarbeitung, Textgenerierung und ähnliche komplexe Aufgaben eingesetzt.

Ein tiefes Verständnis dieser Modelle ist essenziell, da es ermöglicht, das volle Potenzial der KI zu erschließen. Ein oberflächlicher Zugang hingegen lässt wesentliche Möglichkeiten ungenutzt. #prompterledigt