Generative KI: Bausteine, Komponenten bis zur Anwendung

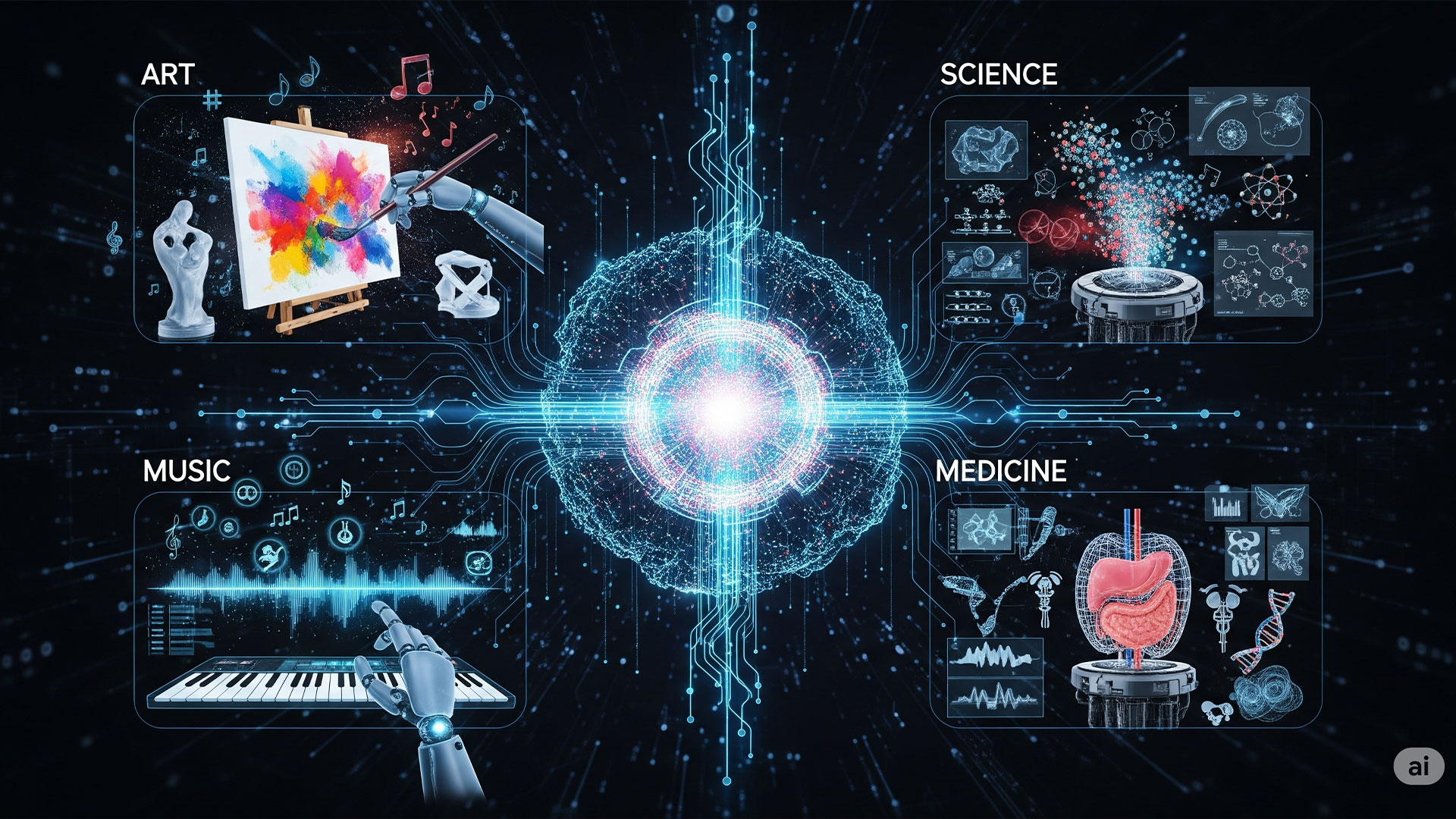

16.08.2025 | In unserem stetig wachsenden digitalen Ökosystem ist die generative künstliche Intelligenz (KI) nicht mehr nur ein abstraktes Konzept, sondern eine treibende Kraft, die unser tägliches Leben in vielen Bereichen verändert. Von der Kunst bis zur Wissenschaft, von der Musik bis zur Medizin – die Fähigkeit von Maschinen, eigenständig neue und originelle Inhalte zu erschaffen, hat eine Revolution ausgelöst. Doch was steckt eigentlich hinter dieser Technologie? Welche Bausteine und Komponenten sind notwendig, um generative KI zu ermöglichen und zu trainieren?

Dieser Blogbeitrag beleuchtet die grundlegenden Elemente der generativen KI und gibt Ihnen einen umfassenden Überblick über die einzelnen Bausteine, die diese faszinierende Technologie erst möglich machen. Von der Datenaufbereitung über verschiedene Modelle bis hin zu den entscheidenden Hardware-Anforderungen – tauchen Sie mit uns ein in die Welt der generativen KI.

Algorithmen:

Neuronale Netze und spezielle Architekturen (z. B. Transformer, GANs, Diffusion Models) bilden die mathematische Basis für das Erzeugen neuer Inhalte durch KI.

Moderne generative KI-Modelle nutzen fortgeschrittene Architekturen wie Transformer, GANs und Diffusion Models. Besonders Multimodalität (Eingabe von Text, Bild und Ton) und lange Kontextfenster sind 2025 Standard. Zum Beispiel ermöglicht Googles Gemini Modelle, die Text und Bild gemeinsam verarbeiten und so komplexe Aufgaben lösen. Diffusionsmodelle, wie sie in Stable Diffusion zum Einsatz kommen, revolutionieren die Bildgenerierung durch ihre Detailgenauigkeit und kreative Flexibilität.

Beispiel: Vergleichen Sie die Ausgaben verschiedener Modelle (ChatGPT, Gemini, Stable Diffusion) zu einem kurzen Prompt und erläutern Sie Unterschiede in Technik und Ergebnis.

Visualisierung: Modellarchitekturen als Übersichtsgrafik integrieren.

- Transformer Architektur verstehen

- GANs und Diffusionsmodelle kennen

- Multimodalität erläutern

- Längere Kontextfenster erläutern

- Beispiele aktueller Modelle (z.B. Gemini)

Anwendungen:

Generativ erstellte Texte, Bilder, Musik, Videos, Code und andere Medien – heute vor allem für Content-Erstellung, Design, Support-Chats und individuelle Interaktion.

- Einsatzgebiete wie Textgenerierung, Bildgenerierung, Sprachsynthese

- Unterstützung in Kreativbranchen, Marketing und Kundenservice

- Generierung von Programmcode und Datenanalyse

- Automatisierung von Dokumentation und Berichten

- Medizinische und wissenschaftliche Forschung durch KI-Analysen

- Individuelle Assistenzsysteme und Chatbots

Bewertungssysteme (Evaluation Metriken):

Verfahren zur Qualitätsmessung der generierten Inhalte, z. B. Perplexity, BLEU, FID, Human-AI-Comparisons – essenziell für Fortschritt und Qualitätskontrolle.

Neben klassischen Metriken wie Perplexity, BLEU und FID gibt es jetzt automatisierte, KI-gestützte Bewertungssysteme und Human-AI-Comparisons, bei denen Menschen und KI gemeinsam die Qualität beurteilen. In der Praxis werden Benchmarks immer komplexer, etwa durch Logik- und Kreativitätsaufgaben.

Datengrundlage (Trainingsdaten):

Hohe Qualität, Vielfalt und Umfang der Trainingsdaten bestimmen maßgeblich, was und wie gut eine KI generieren kann; dabei gibt es große Herausforderungen bei Domain-Shifts, Bias und Datenschutz.

Neben herkömmlichen Trainingsdaten werden zunehmend synthetische Daten und föderiertes Lernen eingesetzt, um Datenschutz und Diversität zu verbessern. Bias-Risiken und Datenschutz bleiben zentrale Herausforderungen.

Ethische Richtlinien:

Regeln für die Entwicklung, den Einsatz und das Monitoring generativer KI, inklusive Fairness, Transparenz, Diskriminierungsvermeidung, Verantwortlichkeit und Folgenabschätzung.

Feedback- & Fine-Tuning-Mechanismen:

Menschliches und automatisiertes Feedback sowie spezielle Feinabstimmungsverfahren (zum Beispiel „RLHF“ = Reinforcement Learning from Human Feedback) schärfen die KI-Modelle.

Hardware:

Leistungsfähige Rechnercluster, GPUs/TPUs und Cloud-Infrastrukturen als technische Voraussetzung für das Training und den Einsatz großer KI-Modelle.

Komponenten-Kreislauf:

In der Regel bestehend aus Datensammlung, Vorverarbeitung, Modelltraining, Inferenz, Evaluation und kontinuierlicher Verbesserung in einem Kreislauf.

Knowledge Grounding (Wissensverankerung):

Verfahren, um externe Wissensquellen (Datenbanken, APIs, Suchmaschinen) in den Generierungsprozess einzubinden und so bessere, aktuellere oder speziellere Inhalte zu produzieren.

Modellarchitekturen:

Transformer, Diffusion Models, GANs, VAEs etc.; jede Architektur hat spezielle Stärken und Limitations für bestimmte Aufgaben.

Open Source & Code-Bibliotheken:

Plattformen und Software-Bibliotheken (TensorFlow, PyTorch, Hugging Face u. a.), die den Zugang, die Entwicklung und das Teilen von generativen KI-Modellen fördern.

Prompt Engineering:

Techniken zur optimalen Formulierung von Aufgabenstellungen (Prompts), damit die gewünschten Ergebnisse mit hoher Qualität erzeugt werden.

Die Effizienz generativer KI hängt stark von der präzisen Formulierung der Prompts ab. Techniken wie Few-Shot Learning, Chain-of-Thought-Prompts und Prompt Tuning erhöhen die Kontrolle über die Ausgaben.

Regulatorische Rahmenbedingungen:

Rechtliche Vorgaben zu Datenschutz, Urheberrecht, Haftung, Transparenz und Zertifizierung von KI-Systemen – international und branchenspezifisch unterschiedlich.

Die EU-KI-Verordnung stellt umfangreiche Vorgaben für Transparenz, Dokumentation und Zertifizierung von Hochrisikoanwendungen auf. Unternehmen müssen Compliance-Prozesse etablieren – Verstöße können zu hohen Geldstrafen führen.

Sicherheit und Robustheit:

Schutz gegen Angriffe (z. B. „Prompt Injections“), Fehlfunktionen und unerwünschtes Verhalten; Entwicklung von Verteidigungsstrategien und Monitoring.

Technische Dokumentation:

Nachvollziehbare, vollständige und verständliche Beschreibung von Modellen, Daten, Trainingsverfahren und Einsatzkontexten – wichtig für Audit, Compliance und Risikomanagement.

Die Dokumentation von KI-Systemen ist für Hochrisikoanwendungen gesetzlich vorgeschrieben. Sie umfasst Datenherkunft, Modelltraining, Einsatzbedingungen und regelmäßige Überprüfung.

Visualisierung: Stellen Sie den Dokumentationsprozess als Flow-Chart dar.

User Interfaces (Nutzerschnittstellen):

Tools und Plattformen, die es Nicht-Experten ermöglichen, mit generativer KI zu arbeiten, z. B. Chat-GPT-Interfaces, Image-Generation-Apps, APIs für Entwickler.

Moderne Interfaces für generative KI reichen von Chatbots über Voice- und Gestensteuerung bis zu AR/VR-Umgebungen. No-UI-Konzepte (KI als unsichtbarer Assistent) sind im Kommen.

Weiterentwicklung & Adaption:

Methoden für kontinuierliches Lernen, Transfer-Learning und Adaption an neue Anwendungsfelder und Sprachen, um die Aktualität und Relevanz der Modelle zu sichern.

Jetzt via WhatsApp teilen | #prompterledigt

Erreichbar über Social Media und sichtbar auf Google

Facebook | Instagram | LinkedIn | WhatsApp | X (Twitter) | Google Seite | Google-Rezension | Bei Fragen gerne per E-Mail an post@achim-weidner.de

Meine Qualifikation

Kernkompetenzen

- Datenschutz-Compliance, IT- und Internet-Compliance, externer Datenschutzbeauftragter, externer Datenschutzkoordinator, generative KI in Unternehmen, KI-Compliance und DSGVO, Social-Media-Governance, KI-gestützte Internetstrategien, digitale Sicherheitskonzepte, agentenbasierte KI-Workflows, Blockchain- und IoT-Diskurse, Digitalisierungsstrategien im Mittelstand

Kurzbeschreibung

- Achim Weidner unterstützt Unternehmen und Institutionen im Raum Frankfurt RheinMain und bundesweit bei Datenschutz, Datensicherheit, sozialer Mediennutzung und generativer KI.

- Im Mittelpunkt stehen praxisorientierte Analysen, Strategien und Schulungsformate zu digitalen Technologien und deren rechtlichen und organisatorischen Folgen.

Professional Service

- Entwicklung und Umsetzung von Datenschutz- und IT-Compliance-Strukturen, inklusive Mandaten als externer Datenschutzkoordinator und externer Datenschutzbeauftragter.

- Übersetzung komplexer KI-, Daten- und Plattformtechnologien in handhabbare Leitlinien, Entscheidungsunterlagen, Schulungen und FAQ-Formate für Geschäftsführung, Fachbereiche und Mitarbeitende.

- Begleitung beim Einsatz generativer KI, beim Aufbau KI-gestützter Internet- und Social-Media-Strategien sowie bei der Bewertung von Risiken, Chancen und regulatorischen Anforderungen.

Person

Er gilt als kompetenter Übersetzer zwischen Technik, Recht und Management, tritt als Referent zu KI, Digitalisierung und Geopolitik auf und nutzt ein breites Weiterbildungsportfolio (u. a. openHPI) für aktuelle, anwendungsnahe Perspektiven.

Achim Weidner verbindet mehr als 25 Jahre operative Erfahrung in digitalen Projekten mit einer zertifizierten Qualifikation in „Rechtliche Aspekte der IT- und Internet-Compliance“ der Carl von Ossietzky Universität Oldenburg, ergänzt durch Abschlüsse als Social Media Manager (IHK) und KI-Manager.

Horizonterweiterung bei openHPI

Chatbots leicht gemacht: Große Sprachmodelle einfach nutzen +++ Lehrkräfteprofessionalisierung für KI in Schule und Unterricht +++ Sustainability in the digital age: Environmental Impacts of AI Systems +++ KI-Biases verstehen und vermeiden +++ Profitable AI +++ Einführung in das Quantencomputing – Teil 1 +++ Digitale Medizin – Was ist ethisch verantwortbar? +++ Digitale Privatsphäre: Wie schütze ich meine persönlichen Daten im Netz? +++ Künstliche Intelligenz und maschinelles Lernen in der Praxis +++ Blick hinter den Hype: Aktuelle Entwicklungen rund um KI, Blockchain und IoT +++ ChatGPT: Was bedeutet generative KI für unsere Gesellschaft? +++ KI und Datenqualität – Perspektiven aus Data Science, Ethik, Normung und Recht +++ Blockchain: Hype oder Innovation? +++ Künstliche Intelligenz und maschinelles Lernen für Einsteiger +++ Blockchain – Sicherheit auch ohne Trust Center

Referententätigkeit

Achim Weidner war als Referent an der Volkshochschule Rüsselsheim und VHS Frankfurt am Main und für die Konrad Adanauer Stiftung tätig, wobei seine Schwerpunkte auf gesellschaftlichen und technologischen Fragestellungen lagen. Zu seinen Vortragsthemen zählten unter anderem: Künstliche Intelligenz (KI), Roboter, Atomforschung, Teilchenbeschleuniger, Digitalisierung, Silicon Valley, Neue Seidenstraße.

Aktuelle Vorträge und Veranstaltungen

- 18.03.2026 | Gewerbeverein Rüsselsheim – KI-Update 2026 – Vom Chatbot zum Agenten

- 16.04.2026 | CUCM KI-Tag: „Mit Daten sprechen“